Arucomover: Unterschied zwischen den Versionen

Aus Hackerspace Ffm

Snow (Diskussion | Beiträge) (Die Seite wurde neu angelegt: „== Ziel == Ein kleiner Robot auf Basis eines Raspberry Pi soll selbstständig Aruco codes finde finden und anfahren können == BOM == Raspberry Pi 3 BNO055…“) |

Snow (Diskussion | Beiträge) |

||

| Zeile 2: | Zeile 2: | ||

Ein kleiner Robot auf Basis eines Raspberry Pi soll selbstständig Aruco codes finde finden und anfahren können | Ein kleiner Robot auf Basis eines Raspberry Pi soll selbstständig Aruco codes finde finden und anfahren können | ||

| + | |||

| + | == Konzept == | ||

| + | |||

| + | Ein Python Script benutzt die OpenCV Library um Arucos im Bild mit Position und Entfernung zu erkennen. | ||

| + | Der Videostream und die Position, Entfernung werden von dem Script zur Verfügung gestellt. | ||

| + | |||

| + | Ein Node-Red Flow Nimmt die Position auf und gibt Stuerbefehle über an einen ItsyBitsy M3, der damit ein MotorShield steuert. | ||

| + | |||

| + | Angeschlossen aber nicht benutzt ist ein BNO055, der SensorDaten Liefert um z.B. die Postionsbestimmung zu verbessern. | ||

| + | |||

| + | Hier eine Übersicht | ||

| + | |||

| + | [[Datei:Arucomover_konzept.jpg ]] | ||

| + | |||

| + | Hier ein Schaltplan dazu | ||

| + | |||

| + | [[Datei:Arucomover diagram.jpg |x200px]] | ||

| + | |||

| + | Es soll aber trotzdem möglich sein, daß ein Benutzer eingreift,dafür die UI aus Node-Red heraus | ||

| + | |||

| + | [[Datei:Arucomoverui.png |x300px]] | ||

| + | |||

| + | == Fortschritte == | ||

| + | |||

| + | == Erste Ergebnisse == | ||

| + | |||

| + | <gallery perrow=6 caption = "Stepps"> | ||

| + | Datei:Arucomover_01.jpg | Start | ||

| + | Datei:Arucomover_02.jpg | Stepp 2 | ||

| + | Datei:Arucomover_03.jpg | Stepp 4 | ||

| + | Datei:Arucomover_04.jpg | Final Hardware | ||

| + | </gallery> | ||

== BOM == | == BOM == | ||

Version vom 1. Juli 2021, 11:47 Uhr

Inhaltsverzeichnis

[Verbergen]Ziel

Ein kleiner Robot auf Basis eines Raspberry Pi soll selbstständig Aruco codes finde finden und anfahren können

Konzept

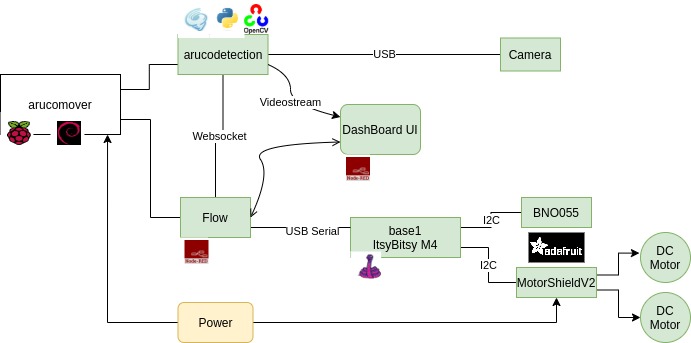

Ein Python Script benutzt die OpenCV Library um Arucos im Bild mit Position und Entfernung zu erkennen. Der Videostream und die Position, Entfernung werden von dem Script zur Verfügung gestellt.

Ein Node-Red Flow Nimmt die Position auf und gibt Stuerbefehle über an einen ItsyBitsy M3, der damit ein MotorShield steuert.

Angeschlossen aber nicht benutzt ist ein BNO055, der SensorDaten Liefert um z.B. die Postionsbestimmung zu verbessern.

Hier eine Übersicht

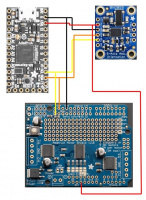

Hier ein Schaltplan dazu

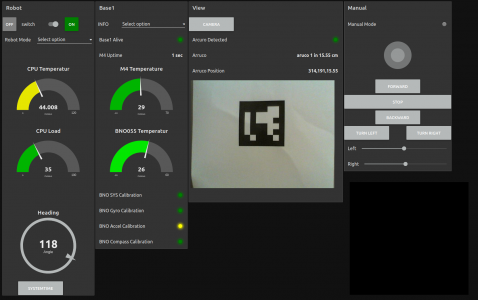

Es soll aber trotzdem möglich sein, daß ein Benutzer eingreift,dafür die UI aus Node-Red heraus

Fortschritte

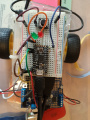

Erste Ergebnisse

- Stepps

BOM

Raspberry Pi 3 BNO055 MotorAeshield V2