Arucomover: Unterschied zwischen den Versionen

Snow (Diskussion | Beiträge) (Die Seite wurde neu angelegt: „== Ziel == Ein kleiner Robot auf Basis eines Raspberry Pi soll selbstständig Aruco codes finde finden und anfahren können == BOM == Raspberry Pi 3 BNO055…“) |

Snow (Diskussion | Beiträge) |

||

| (8 dazwischenliegende Versionen desselben Benutzers werden nicht angezeigt) | |||

| Zeile 1: | Zeile 1: | ||

== Ziel == | == Ziel == | ||

| − | Ein kleiner | + | [[Datei:Arucomover.jpg |x300px]] |

| + | |||

| + | Ein kleiner Roboter auf Basis eines Raspberry Pi soll selbstständig Arucocodes finden und anfahren können. | ||

| + | |||

| + | == Konzept == | ||

| + | |||

| + | Ein Python Script benutzt die OpenCV Library um Arucos im Bild mit Positionen und Entfernung zu erkennen. | ||

| + | Der Videostream und die Position mit Entfernung werden von dem Script zur Verfügung gestellt. | ||

| + | |||

| + | Ein Node-Red Flow nimmt die Position auf und gibt Steuerbefehle an einen ItsyBitsy M3, der damit ein MotorShield steuert. | ||

| + | |||

| + | Angeschlossen aber nicht benutzt ist ein BNO055, der Sensordaten liefert um z.B. die Positionsbestimmung zu verbessern. | ||

| + | |||

| + | Hier eine Übersicht | ||

| + | |||

| + | [[Datei:Arucomover_konzept.jpg ]] | ||

| + | |||

| + | Hier ein Schaltplan dazu. | ||

| + | |||

| + | [[Datei:Arucomover diagram.jpg |x200px]] | ||

| + | |||

| + | Mit dem Dashboard UI aus Node Red heraus ist es möglich, dass der Benutzer steuern kann. | ||

| + | |||

| + | Die erkannten Aruco IDs werden angezeigt. Ist eine ID erkannt worden, kann User Automatic wählen. | ||

| + | |||

| + | Automatic heißt,der Flow steuert den Robot auf den Aruco Code und stoppt den Robot kurz davor | ||

| + | |||

| + | Der Zustand des Bots (Load, Temperaturen, Calibration) wird auch angezeigt. | ||

| + | |||

| + | [[Datei:Arucomoverui.png |x300px]] | ||

| + | |||

| + | |||

| + | == Setup == | ||

| + | Der Code und auch ein Setup können aus https://github.com/hackffm/arucomover geladen werden. | ||

| + | Das Ganze läuft auf einem Debian basiertem Linux. Also Ubuntu oder Raspian. Im Setup Folder gibt es Skripte, die das Allermeiste | ||

| + | vorbereiten sollten. | ||

| + | <br> | ||

| + | Das Skript arucodetection.py verwendet Shared Memory ! | ||

| + | <br> | ||

| + | Erst ab Python 3.8 ist Shared Memory verfügbar. Auf einem RaspberryPi3 ist 3.7 default. Daher | ||

| + | gibt es im Setup Folder das Hilfskript setup_python3_9.sh für den Pi 3.<br> | ||

| + | |||

| + | Vor der Ausführung der Setups muss das Swapfile auf eine Raspberry vergrößert werden. | ||

| + | |||

| + | <code> | ||

| + | sudo nano /etc/dphys-swapfile -> CONF_SWAPSIZE=1024 | ||

| + | |||

| + | sudo /etc/init.d/dphys-swapfile restart | ||

| + | </code> | ||

| + | |||

| + | Ein gutes Netzteil vorrausgesetzt, läuft das dann einige Zeit. Die übrigen Setup | ||

| + | Skripte können, mit der richtigen Python Version dann ausgeführt werden. | ||

| + | Der Schritt 2_setup_folders.sh installiert auch alle Python Requierements. | ||

| + | Das kann auf einem PI 3 mehrere Stunden dauern, da diverse Kompilierungen im Hintergrund laufen ! | ||

| + | |||

| + | == Arucodetetcion == | ||

| + | ist ein Pythoncode, der von dieser Seite [[OpenCV_mit_Python]] inspiriert ist und in zwei Prozessen läuft: | ||

| + | Web und Arucodetecion. Damit der Webprozess die Arcuoposition über einen Websocket liefern kann, sind | ||

| + | beide über eine Managed Queue verbunden. Der Videostream wird in ein Shared Memory | ||

| + | geschrieben und vom Webprozess geholt. Dies ist erst ab Python 3.8 möglich ! | ||

| + | Default für den Kameraanschluss ist "Camera Device 0". Sollte eine | ||

| + | Kalibrierung für eine bessere Erkennung notwendig sein, kann ein entsprechendes | ||

| + | Config File camera.json mit create_camera_config.py erstellt werden. Dies muss dann in den | ||

| + | vom Setup erstellten /USERHOME/arucodetection Folder kopiert werden. | ||

| + | Dort liegt auch eine config.json mit der sich die Kamera, Auflösung, Debug usw. einstellen läßt. | ||

| + | Das Log landet in ~/arucdetection/log. | ||

| + | Default ist DICT_6X6_50 für den Arucocode! Dies kann zur Zeit nur in der camera.py umgestellt werden. | ||

| + | |||

| + | Um zu testen ob alles funktioniert, stellt arucodetection.py eine entsprechende Webseite zur Verfügung, | ||

| + | die Websocket und Videostream abfragt. | ||

| + | |||

| + | Die Webseite ist auf 127.0.0.1:9080 zu finden | ||

| + | |||

| + | [[Datei:Arucodetection.jpg |x300px ]] | ||

| + | |||

| + | == itsyBitsyM4== | ||

| + | Die verwendeten libraries müssen im lib Folder vorhanden sein und eventuell nachinstalliert werden. | ||

| + | Z.B. adafruit_bno055. Diese müssen zur CircuitPython Version des M4 passen. | ||

| + | |||

| + | code.py ist der ausgeführte Code. Der I2C Test ist in diesen eingebaut. Alle verfügbaren Kommandos können | ||

| + | mit ? abgefragt werden. Will man nur I2C testen, kann man auch code.py umbenennen. Dann wird automatisch main.py | ||

| + | aufgerufen, dass in einer Endlosschleife die angeschlossenen I2C Devices abfragt. | ||

| + | |||

| + | == Node-Red == | ||

| + | |||

| + | Entweder durch die Setup Skripte oder so sollte ein Node.js 14x vorhanden sein. | ||

| + | Wenn das Skript 2_setup_folders.sh nicht ausgeführt wurde muss selbst dafür gesorgt werden, dass | ||

| + | das Package.json File in ~/nodered/ abgelegt wurde und alle Package Depencies darin installiert wurden. | ||

| + | |||

| + | node_red_start.sh führt Folgendes aus: | ||

| + | |||

| + | <code> | ||

| + | node red --settings ~/git/arucomover/code/nodered/arucomover.js --flowFile ~/git/arucomover/code/nodered/flows_arucomover.json | ||

| + | </code> | ||

| + | |||

| + | Das Settings File startet NodeRed auf Port 9010<br> | ||

| + | Editor => http:;//127.0.0.1:9010 und<br> | ||

| + | UI => http:;//127.0.0.1:9010/ui<br> | ||

| + | <br> | ||

| + | Der Flow ist in zwei Tabs aufgeteilt.<br> | ||

| + | Ein Tab für die Daten von ItsyBitsy M4 und arucomover.py<br> | ||

| + | Ein Tab für die Steuerbefehle an den ItsyBitsy M4<br> | ||

| + | Beide Tabs habe UI Elemente und sind miteinander verbunden um ein einheitliches Handling zu ermöglichen.<br> | ||

| + | <br> | ||

| + | |||

| + | == Start == | ||

| + | |||

| + | Es müssen zwei Prozesse gestartet werden also entweder nacheinander mit & in den Hintergrund oder z.B. mit screen oder tmux. | ||

| + | |||

| + | 1.Start der arucodetection<br> | ||

| + | <code> | ||

| + | source ~/arucodetection/venv/bin/activate | ||

| + | |||

| + | ...../arucomover/code/arucodetection/arucodetection.py | ||

| + | |||

| + | </code> | ||

| + | |||

| + | 2.Start der Node-Red Flows<br> | ||

| + | <code> | ||

| + | ...../arucodetection/cosde/bash/node_red_start.sh | ||

| + | </code> | ||

| + | |||

| + | == Hardware Evolution == | ||

| + | |||

| + | <gallery perrow=6 caption = "Stepps"> | ||

| + | Datei:Arucomover_01.jpg | Start | ||

| + | Datei:Arucomover_02.jpg | Stepp 2 | ||

| + | Datei:Arucomover_03.jpg | Stepp 4 | ||

| + | Datei:Arucomover_04.jpg | Final Hardware | ||

| + | </gallery> | ||

== BOM == | == BOM == | ||

| − | Raspberry Pi 3 | + | Raspberry Pi 3<br> |

| − | BNO055 | + | BNO055<br> |

MotorAeshield V2 | MotorAeshield V2 | ||

Aktuelle Version vom 10. Juli 2021, 13:53 Uhr

Inhaltsverzeichnis

[Verbergen]Ziel

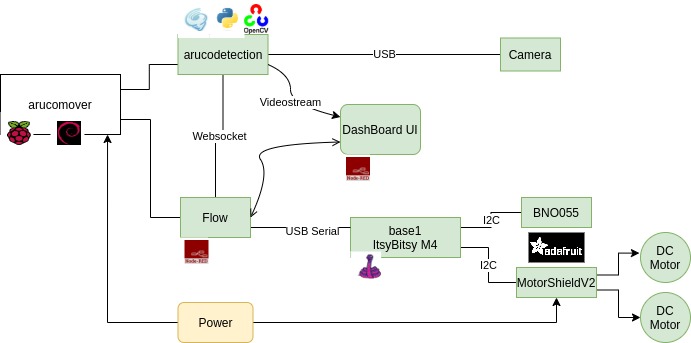

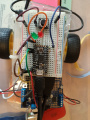

Ein kleiner Roboter auf Basis eines Raspberry Pi soll selbstständig Arucocodes finden und anfahren können.

Konzept

Ein Python Script benutzt die OpenCV Library um Arucos im Bild mit Positionen und Entfernung zu erkennen. Der Videostream und die Position mit Entfernung werden von dem Script zur Verfügung gestellt.

Ein Node-Red Flow nimmt die Position auf und gibt Steuerbefehle an einen ItsyBitsy M3, der damit ein MotorShield steuert.

Angeschlossen aber nicht benutzt ist ein BNO055, der Sensordaten liefert um z.B. die Positionsbestimmung zu verbessern.

Hier eine Übersicht

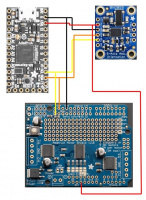

Hier ein Schaltplan dazu.

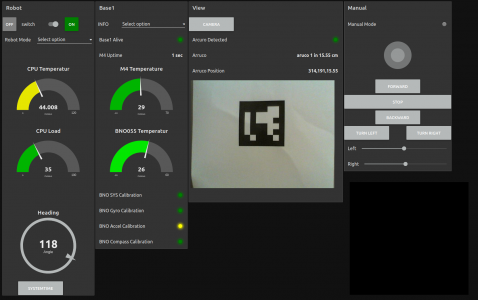

Mit dem Dashboard UI aus Node Red heraus ist es möglich, dass der Benutzer steuern kann.

Die erkannten Aruco IDs werden angezeigt. Ist eine ID erkannt worden, kann User Automatic wählen.

Automatic heißt,der Flow steuert den Robot auf den Aruco Code und stoppt den Robot kurz davor

Der Zustand des Bots (Load, Temperaturen, Calibration) wird auch angezeigt.

Setup

Der Code und auch ein Setup können aus https://github.com/hackffm/arucomover geladen werden.

Das Ganze läuft auf einem Debian basiertem Linux. Also Ubuntu oder Raspian. Im Setup Folder gibt es Skripte, die das Allermeiste

vorbereiten sollten.

Das Skript arucodetection.py verwendet Shared Memory !

Erst ab Python 3.8 ist Shared Memory verfügbar. Auf einem RaspberryPi3 ist 3.7 default. Daher

gibt es im Setup Folder das Hilfskript setup_python3_9.sh für den Pi 3.

Vor der Ausführung der Setups muss das Swapfile auf eine Raspberry vergrößert werden.

sudo nano /etc/dphys-swapfile -> CONF_SWAPSIZE=1024

sudo /etc/init.d/dphys-swapfile restart

Ein gutes Netzteil vorrausgesetzt, läuft das dann einige Zeit. Die übrigen Setup Skripte können, mit der richtigen Python Version dann ausgeführt werden. Der Schritt 2_setup_folders.sh installiert auch alle Python Requierements. Das kann auf einem PI 3 mehrere Stunden dauern, da diverse Kompilierungen im Hintergrund laufen !

Arucodetetcion

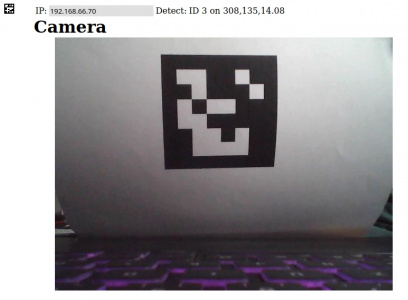

ist ein Pythoncode, der von dieser Seite OpenCV_mit_Python inspiriert ist und in zwei Prozessen läuft: Web und Arucodetecion. Damit der Webprozess die Arcuoposition über einen Websocket liefern kann, sind beide über eine Managed Queue verbunden. Der Videostream wird in ein Shared Memory geschrieben und vom Webprozess geholt. Dies ist erst ab Python 3.8 möglich ! Default für den Kameraanschluss ist "Camera Device 0". Sollte eine Kalibrierung für eine bessere Erkennung notwendig sein, kann ein entsprechendes Config File camera.json mit create_camera_config.py erstellt werden. Dies muss dann in den vom Setup erstellten /USERHOME/arucodetection Folder kopiert werden. Dort liegt auch eine config.json mit der sich die Kamera, Auflösung, Debug usw. einstellen läßt. Das Log landet in ~/arucdetection/log. Default ist DICT_6X6_50 für den Arucocode! Dies kann zur Zeit nur in der camera.py umgestellt werden.

Um zu testen ob alles funktioniert, stellt arucodetection.py eine entsprechende Webseite zur Verfügung, die Websocket und Videostream abfragt.

Die Webseite ist auf 127.0.0.1:9080 zu finden

itsyBitsyM4

Die verwendeten libraries müssen im lib Folder vorhanden sein und eventuell nachinstalliert werden. Z.B. adafruit_bno055. Diese müssen zur CircuitPython Version des M4 passen.

code.py ist der ausgeführte Code. Der I2C Test ist in diesen eingebaut. Alle verfügbaren Kommandos können mit ? abgefragt werden. Will man nur I2C testen, kann man auch code.py umbenennen. Dann wird automatisch main.py aufgerufen, dass in einer Endlosschleife die angeschlossenen I2C Devices abfragt.

Node-Red

Entweder durch die Setup Skripte oder so sollte ein Node.js 14x vorhanden sein. Wenn das Skript 2_setup_folders.sh nicht ausgeführt wurde muss selbst dafür gesorgt werden, dass das Package.json File in ~/nodered/ abgelegt wurde und alle Package Depencies darin installiert wurden.

node_red_start.sh führt Folgendes aus:

node red --settings ~/git/arucomover/code/nodered/arucomover.js --flowFile ~/git/arucomover/code/nodered/flows_arucomover.json

Das Settings File startet NodeRed auf Port 9010

Editor => http:;//127.0.0.1:9010 und

UI => http:;//127.0.0.1:9010/ui

Der Flow ist in zwei Tabs aufgeteilt.

Ein Tab für die Daten von ItsyBitsy M4 und arucomover.py

Ein Tab für die Steuerbefehle an den ItsyBitsy M4

Beide Tabs habe UI Elemente und sind miteinander verbunden um ein einheitliches Handling zu ermöglichen.

Start

Es müssen zwei Prozesse gestartet werden also entweder nacheinander mit & in den Hintergrund oder z.B. mit screen oder tmux.

1.Start der arucodetection

source ~/arucodetection/venv/bin/activate

...../arucomover/code/arucodetection/arucodetection.py

2.Start der Node-Red Flows

...../arucodetection/cosde/bash/node_red_start.sh

Hardware Evolution

- Stepps

BOM

Raspberry Pi 3

BNO055

MotorAeshield V2